RankBrain: la evolución del algoritmo de Google

Google utiliza un algoritmo con capacidad de autoaprendizaje. Con esta declaración, el neurocientífico Greg Corrado, impulsor del proyecto Google Brain, sorprendió durante una entrevista de la agencia Bloomberg el 15 de octubre de 2015, en donde confirmó que Google se apoya en la inteligencia artificial (IA) para interpretar las consultas de los usuarios utilizando un sistema llamado “RankBrain”, ya integrado en el algoritmo del buscador meses antes de la publicación de la entrevista. En realidad, hace mucho se sabe que Google lleva años invirtiendo en la investigación de la inteligencia artificial. Ya en 2012 la empresa californiana reclutó al visionario de la tecnología Raymond Kurzweil como director de ingeniería, gesto al que le siguió la adquisición de la startup especializada en sistemas de IA DeepMind en 2014 por unos 500 millones de euros. Con RankBrain los esfuerzos de Google en el terreno de la investigación de la IA dan un paso más y entran en el negocio principal de la compañía. Ahora bien ¿es tan inteligente esta nueva tecnología? ¿Qué efectos tiene el algoritmo RankBrain en el día a día de webmasters y expertos en SEO?

¿Qué es RankBrain?

Según Corrado, RankBrain lleva utilizándose desde principios de 2015 como componente del algoritmo de búsqueda Hummingbird (colibrí en español), aunque al principio se limitaba a las consultas desconocidas. De las cerca de tres mil millones de consultas que procesa el buscador a diario, alrededor de un quince por ciento consiste, según informa Google, en palabras y combinaciones aún desconocidas en esa forma por el algoritmo, que incluyen incluso términos coloquiales, de nueva creación o frases complejas de cola larga. En 2016 RankBrain ve ampliado su campo de acción a la totalidad de las búsquedas en Google, de tal forma que hoy la tecnología está involucrada en el procesamiento de todas las consultas introducidas en el buscador.

una palabra clave de cola larga (longtail keyword) es un término que puede estar compuesto por un número indeterminado de palabras hasta llegar a constituir incluso una frase. Al contrario, una palabra clave shorthead define una consulta concisa que utiliza menos vocablos. Podemos verlo con este ejemplo: “cómo funciona un servidor cloud” frente a “servidor cloud”.

La tarea principal de RankBrain consiste básicamente en la interpretación de las palabras y frases de cada consulta con el fin de deducir la intención del usuario. En el mencionado artículo publicado por Bloomberg se habla de RankBrain como un sistema de inteligencia artificial capaz de aprender por sí mismo, pero ¿qué entiende Google por inteligencia artificial y cómo funciona RankBrain exactamente?

Machine Learning: Making Sense of a Messy World (Google via YouTube) (fuente: www.youtube.com/watch?v=l95h4alXfAA)

Antes de RankBrain: 60 años investigando la inteligencia artificial

Si algo sigue estando claro a día de hoy es que el ordenador que piensa por sí mismo y la singularidad tecnológica tal como la pronosticaron los futuristas siguen siendo ciencia ficción. En realidad, la investigación de la inteligencia artificial lleva más de sesenta años ocupándose de la automatización del comportamiento inteligente, pero en vano se busca una definición unitaria del término “inteligencia artificial”, incluso del término “inteligencia” en sí. El nacimiento de la investigación en IA suele situarse en la Conferencia de Dartmouth de 1956. En la propuesta de investigación que presentan los científicos John McCarthy, Marvin Minsky, Nathaniel Rochester y Claude Shannon en el norteamericano Dartmouth College en 1955 se mencionan conceptos que aún hoy suenan a ficción, tales como ordenadores automáticos, síntesis lingüística, redes neuronales y machine learning así como observaciones sobre abstracción, azar y creatividad. John McCarthy, uno de los responsables principales, es quien acuña el término de “Artificial Intelligence” («inteligencia artificial») desconocido hasta ese momento para englobar estos conceptos en la conferencia del 56. Así, el multipremiado informático (Premio Turing en 1971) sentó las bases de un nuevo campo de estudio interdisciplinar cuyos intereses para el proyecto mencionado definió de la siguiente manera: “For the present purpose the artificial intelligence problem is taken to be that of making a machine behave in ways that would be called intelligent if a human were so behaving.” (John McCarthy, 1955). Una definición parecida se encuentra aún hoy en la Enciclopedia Británica.

Artificial intelligence (AI), the ability of a digital computer or computer-controlled robot to perform tasks commonly associated with intelligent beings. (Encyclopaedia Britannica)

Ya en 1950, el pionero de la informática Alan Turing propuso un experimento para probar de forma objetiva la inteligencia de una máquina. En el llamado test de Turing, un examinador conduce una conversación con dos interlocutores desconocidos utilizando exclusivamente un teclado y un monitor, de forma que no se tiene contacto visual ni auditivo. El objetivo de ambos interlocutores, una persona y una máquina, es convencer a su interlocutor humano de que trata con un ente pensante. Turing estableció que la máquina superaría la prueba si el examinador, aun con toda la información que ha podido obtener en esta conversación, no pudiera asegurar totalmente cuál de los dos interlocutores es la máquina. Invencible hasta ahora, el test de Turing fue superado por el chatbot Eugene Goostman en 2014, levantando una gran expectación, pero también una viva polémica entre muchos expertos. Los críticos ponen en tela de juicio que la prueba desarrollada por Turing esté en condiciones de probar la existencia de la inteligencia de las máquinas, porque, en definitiva, este test imita una conversación entre personas, cuando la habilidad lingüística solo refleja un aspecto de la inteligencia humana. El test de Turing solo comprueba si las señales que emite la máquina se pueden interpretar como comportamiento inteligente. La misma existencia de inteligencia en la forma de algún tipo de intencionalidad o de conciencia, en cambio, no se somete a examen. En la práctica esta diferenciación tiene un significado secundario, porque en el contexto que nos ocupa es la funcionalidad de los sistemas de IA lo más importante. Este acercamiento práctico a la investigación de la IA se refleja en esta definición de la informática Elaine Rich: “La inteligencia artificial consiste en estudiar cómo hacer que los ordenadores hagan cosas que, por ahora, saben hacer mejor las personas”.

«Artificial Intelligence is the study of how to make computers do things at which, at the moment, people are better» (Elaine Rich, 1983)

Esto nos lleva a aclarar la distinción entre los dos tipos de inteligencia artificial, la fuerte y la débil:

- Inteligencia Artificial Fuerte (Strong Artificial Intelligence): para corresponderse con esta definición, una máquina debería poseer cualidades intelectuales parecidas a las humanas para ser considerada inteligente. Además de la capacidad para extraer conclusiones y resolver problemas, aquí se engloban cualidades como la conciencia, el autoconocimiento, la autopercepción, la sensibilidad y la sabiduría. El objetivo es crear la inteligencia.

- Inteligencia Artificial Débil (Weak Artificial Intelligence): según este concepto, basta con equipar a una máquina con cualidades asociadas a personas con una conducta inteligente. El objetivo sería, en este caso, imitar con reglas matemáticas el comportamiento humano inteligente con cualidades como el pensamiento lógico, la toma de decisiones, la capacidad de planificar y de aprender y la comunicación.

Cuando Google se refiere a RankBrain como un sistema de IA capaz de aprender lo hace en función de la definición débil de la inteligencia artificial, ya que se trata de una tecnología que busca soluciones automáticas a problemáticas que hasta ahora eran procesadas por personas. Como la mayoría de sistemas de este tipo, RankBrain también recurre a las técnicas del aprendizaje automático.

Por aprendizaje automático o aprendizaje de las máquinas (del inglés «machine learning») se entiende la generación artificial de conocimiento a partir de la experiencia. Los sistemas de aprendizaje automático analizan grandes volúmenes de datos, identifican patrones, tendencias y conexiones transversales con ayuda de algoritmos matemáticos y basándose en ellos elaboran sus propias predicciones. En nuestra guía profundizamos en los sistemas de aprendizaje automático y en sus diversas posibilidades de aplicación en el contexto del marketing online y el análisis web.

RankBrain constituye por definición un sistema de inteligencia artificial débil que se apoya en técnicas propias del aprendizaje automático y colabora en la interpretación de las consultas de los usuarios con el algoritmo de búsqueda de Google.

¿Cómo funciona RankBrain?

RankBrain es utilizado por Google para interpretar las consultas de los usuarios y seleccionar en el índice de Google, una base de datos de cerca de mil millones de gigabytes, exactamente aquellas páginas web que más se acercan a la intención del usuario. Para ello, este sistema de IA va más allá del mero cotejo de términos clave.

Ya con la actualización de Hummingbird en agosto de 2013, Google implantó la denominada búsqueda semántica. Mientras que, antes de esta actualización, los términos y las combinaciones de palabras que se utilizaban para buscar se evaluaban de forma estática sin relación de sentido, con la mencionada actualización del algoritmo el significado de la búsqueda pasa a ocupar un lugar central. Con RankBrain, Google completa la búsqueda semántica con un sistema capaz de aprender por sí solo y de recurrir a conocimiento adquirido para responder a búsquedas nuevas y desconocidas.

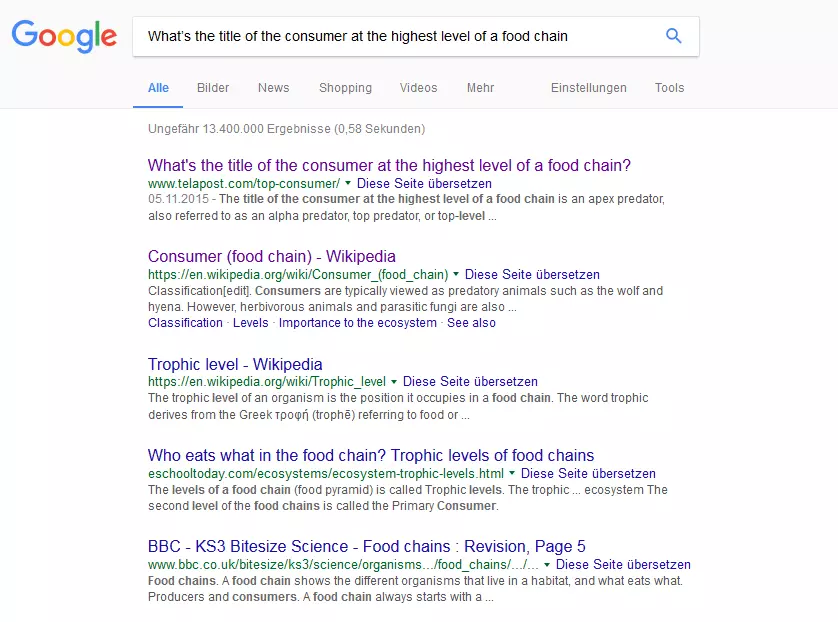

Ante Bloomberg, Google ejemplifica el funcionamiento de RankBrain con esta búsqueda:

“What’s the title of the consumer at the highest level of a food chain”

En lugar de analizar cada palabra de forma aislada, RankBrain registra la semántica de la consulta con un sentido global, determinando así la intención del usuario. Es así como, a pesar de ser una búsqueda de cola larga, el usuario obtiene rápidamente una respuesta a su pregunta.

Para cumplir con su tarea, RankBrain recurre a la experiencia que ha acumulado con consultas anteriores, crea conexiones y se basa en ellas para predecir lo que busca cada usuario y escoger la mejor manera de responder a su consulta. Para ello intenta resolver cualquier ambigüedad y deducir el sentido de términos desconocidos hasta el momento como neologismos, por ejemplo. Obviamente, Google no revela cómo se enfrenta a este desafío, aunque los expertos en SEO sospechan que RankBrain traduce las consultas con ayuda de representaciones vectoriales de palabras en una forma que permite a los ordenadores deducir relaciones semánticas. Ya en 2013, Google lanza Word2Vec, un software de aprendizaje automático de código abierto con el que transformar, medir y comparar las relaciones semánticas entre palabras en una representación matemática. Para poder llevar a cabo este análisis es necesario contar con un corpus lingüístico de base. Para “aprender” las relaciones semánticas entre las palabras, Word2Vec genera en un primer momento un espacio vectorial multidimensional (n-dimensional) en el que cada palabra del corpus subyacente es representada por un vector en tantas dimensiones como defina el valor n. Cuantas más dimensiones se seleccionen, más relaciones con otras palabras es capaz de reconocer el programa. En un siguiente paso, este espacio vectorial se introduce en una red neuronal que permite, con ayuda de un algoritmo de aprendizaje, ajustar el espacio vectorial de tal manera que las palabras que se utilizan en el mismo contexto generen un vector parecido. La semejanza entre vectores se calcula a partir de la denominada distancia de coseno como un valor entre -1 y +1. En definitiva, si se proporciona un corpus lingüístico cualquiera a Word2Vec como input, el programa entrega los correspondientes vectores como output, los cuales permiten evaluar la cercanía o la distancia semántica de las palabras contenidas en el corpus. Si el programa se enfrenta a un input nuevo, el algoritmo de aprendizaje le capacita para reajustar el espacio vectorial y crear nuevas conexiones semánticas o rechazar conclusiones anteriores. Es así como la red neuronal “aprende”.

con la ayuda de las redes neuronales, los investigadores de la inteligencia artificial intentan imitar los principios de organización y procesamiento del cerebro humano. Su objetivo consiste en desarrollar sistemas que estén capacitados para tratar con vaguedades o ambigüedades en la solución de problemas y de esta manera puedan encargarse de tareas que hasta ahora se reservaban para las personas. Las redes neuronales encuentran aplicación en el reconocimiento facial automático de Google, por ejemplo.

Oficialmente, Google no deja ver ninguna relación entre la forma de funcionar de Word2Vec y el algoritmo RankBrain, pero oficiosamente cabe suponer que el sistema de IA está basado en operaciones matemáticas parecidas.

RankBrain y SEO

Más sorprendente aún que el hecho de hacer público que los resultados de la investigación en IA de Google influyen en la búsqueda web es la forma en que lo hacen: Google no solo permite a RankBrain interpretar la totalidad de las consultas desde 2016, sino que, de nuevo según Corrado, RankBrain se ha convertido en el tercer factor de ranking más importante en el algoritmo de búsqueda de Google.

RankBrain se sitúa, a juzgar por la información proporcionada por Google, como el tercer factor de ranking en la búsqueda web. Los dos primeros puestos los comparten el contenido y los enlaces (Andrey Lipattsev, Search Quality Senior Strategist en Google)

Para los administradores web y los expertos en SEO esto obliga a un cambio de perspectiva sobre la estrategia de palabras clave porque Google, en calidad de buscador semántico, está en situación de utilizar conocimiento adquirido, en la forma de conceptos y conexiones, para deducir el significado de cualquier consulta. Esto significa que si una página web posiciona bien para una consulta determinada no depende tanto de si contiene el término de búsqueda concreto como de la relevancia del contenido de la página web respecto al concepto que RankBrain vincula con ese término clave: la prioridad no se concentra tanto en la palabra clave en sí como en la relevancia del contenido de la página web. A esta conclusión llega también la empresa de software Searchmetrics, presente en el SEO internacional con una plataforma de marketing de búsqueda y de contenido y que desde 2012 publica una reputada serie de estudios a propósito de los factores centrales de ranking del algoritmo de Google. La clásica lista general y universal de factores de SEO, tal como la conocemos hasta ahora, está obsoleta si hacemos caso a la conclusión central del último estudio, que data de 2016. Con el título de «Searchmetrics Ranking Factors - Rebooting for Relevance», Searchmetrics examina los últimos cambios en Google para llegar a la conclusión de que los factores de ranking, entendidos de forma generalizada, ya no se corresponden con el estado actual de la evolución del buscador. Los administradores web deberían concentrarse más bien en la relevancia del contenido y situar al usuario en el centro de la estrategia. Sin embargo, los requisitos de los usuarios respecto a las páginas web varían significativamente en función del sector. Esto ha llevado a la compañía a anunciar que en el futuro se dedicará a elaborar estudios diferenciados.

gracias a RankBrain, la relevancia del contenido y la intención del usuario vuelven a situarse en el foco de atención de la optimización para los buscadores.

Con el fin de estudiar la relación entre el ranking de una web y su relevancia para el término utilizado en la consulta, en su último estudio Searchmetrics también utiliza un software de word embedding que traduce relaciones semánticas en vectores. Partiendo de un conjunto de 10.000 palabras clave, la empresa extrajo la relevancia de contenido para cada término clave de los primeros veinte resultados ocultando la palabra clave. Para ello, los analistas eliminaron el término de búsqueda analizado de los textos de las páginas web clasificadas y determinaron para el resto del contenido una nota de relevancia del 0 al 100, el cual se ponía en relación con la posición en la lista de resultados.

El estudio puso de relieve que aquellas páginas posicionadas en los primeros puestos se distinguían por una relevancia de contenido mucho más elevada que aquellas peor clasificadas. La relevancia más alta extraída por Searchmetrics fue para páginas web entre la tercera y la sexta posición. No hay que olvidar que las dos primeras posiciones a menudo están ocupadas por páginas corporativas que, según afirma Searchmetrics, se benefician de un factor de marca adicional.

aun con el mejor contenido solo se alcanza la cima del ranking de Google con el fundamento técnico adecuado. Las mejores páginas son accesibles para el hombre y la máquina de la misma manera. Factores centrales, además del tiempo de descarga y del tamaño de los archivos, son la estructura de la página web y la arquitectura interna de enlaces. Desde la actualización Mobile Friendly, una página diseñada con una arquitectura adaptada a la visualización en terminales móviles también forma parte de las condiciones técnicas básicas para tener éxito en la web.

Dicho esto: ¿cómo reaccionan los webmasters a RankBrain y al resto de cambios? Searchmetrics menciona el diseño editorial holístico como factor central para el éxito, es decir, una creación de contenido que, en lugar de guiarse por palabras clave, lo hace por temas teniendo siempre en cuenta al usuario de forma prioritaria. El objetivo es responder así a las consultas que se hacen en Google con contenido relevante. Para ello, los administradores web deberían obtener la intención de búsqueda para todas las palabras clave con las cuales quieren posicionar. Solo de esta forma se pueden estructurar los términos clave y agruparlos en campos temáticos que han de servir como piedra angular en la elaboración del plan editorial y en la creación de textos cualitativos y ricos en contenido. En nuestra serie de artículos a propósito de la búsqueda, el análisis y la estrategia de palabras clave puedes profundizar en el uso de las palabras clave.