Hyperscale computing: equilibrio de carga para grandes volúmenes de datos

Los big data y la computación en la nube son temas de rabiosa actualidad. Conceptos como industria 4.0, Internet de las cosas y conducción autónoma están en boca de todos. Estas tecnologías requieren la conexión en red de gran cantidad de sensores, dispositivos y máquinas, lo que genera ingentes cantidades de datos que deben procesarse en tiempo real y convertirse inmediatamente en acciones in situ. Estos volúmenes de datos crecen a ritmo exponencial en todos los ámbitos, tanto empresariales como privados, así como en la ciencia y la investigación. Actualmente, producimos aproximadamente 220 000 mensajes de Instagram y 280 000 tuits cada minuto, así como 205 millones de correos electrónicos.

No siempre es posible predecir qué capacidades se requieren de los servidores en todo momento. Para poder reaccionar a estas fluctuaciones, las capacidades de los servidores deben ser escalables. En esta guía de hyperscale computing, obtendrás más información sobre las estructuras físicas necesarias para ello y cómo conectarlas mejor entre sí. Con estos conocimientos, podrás decidir qué soluciones de servidor concretas se adaptan mejor a tus necesidades.

IONOS Cloud Compute Engine

Empresas medianas y grandes eligen la nube "made in Germany". IaaS y Paas son servicios hechos para quienes están dispuestos a ganar.

¿Qué es hyperscale?

El término hyperscale puede traducirse al castellano como “escalabilidad desmesurada” y se utiliza en el mundo de la informática para describir una forma específica de organización de servidores.

Hyperscale: describe sistemas de computación en nube escalables en los que un gran número de servidores están conectados en red. El número de servidores en uso puede aumentarse o reducirse según sea necesario. Una red de este tipo puede gestionar un enorme número de accesos, pero también puede proporcionar capacidades más bajas con cargas de trabajo menores.

La escalabilidad es la expresión del hecho de que la red se adapte a requisitos de rendimiento fluctuantes. Los servidores de hyperscale son sistemas pequeños y sencillos que se adaptan con precisión a un propósito concreto. Para lograr la escalabilidad, se conectan en red horizontalmente. En este caso, horizontal describe el procedimiento de ir añadiendo capacidades de servidor adicionales para aumentar el rendimiento de un sistema informático. En el uso internacional, esto también se conoce como scale-out.

El método opuesto, el de la escalabilidad vertical (scale-up), describe la expansión de un sistema local existente. Para esto, se actualiza el sistema informático mejorando su hardware, es decir, añadiendo una memoria principal más grande, una CPU más rápida, discos duros más potentes o tarjetas gráficas más rápidas. En la práctica, antes de la escalada horizontal, se suele primero actualizar la tecnología in situ, hasta los límites de lo técnica o económicamente factible. A continuación, casi siempre se debe dar el paso al hyperscale.

¿Cómo funciona el hyperscale?

En el hyperscale computing, muchos servidores simples se conectan horizontalmente en red. La palabra “simple” aquí no se refiere a “primitivo”, sino “fácil de conectar”. De este modo, hay menos protocolos, y los que hay son básicos, como, por ejemplo, protocolos de red. Esto hace la comunicación entre servidores fácil de administrar.

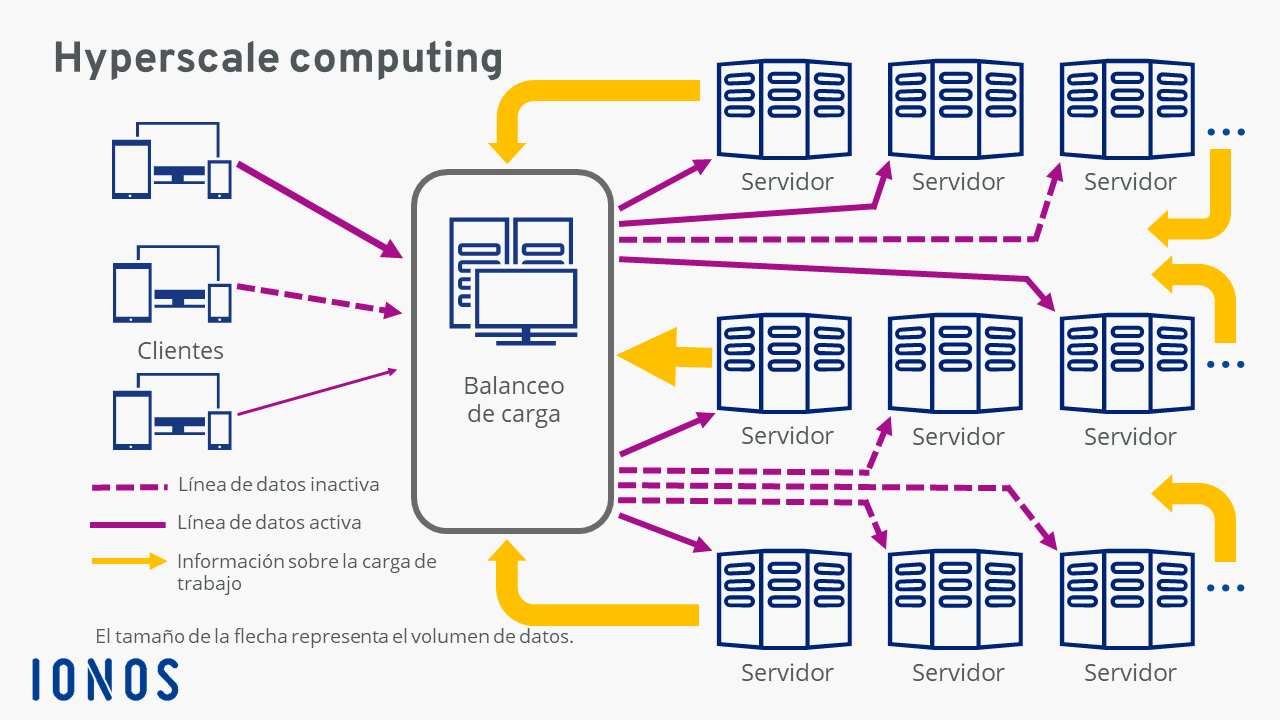

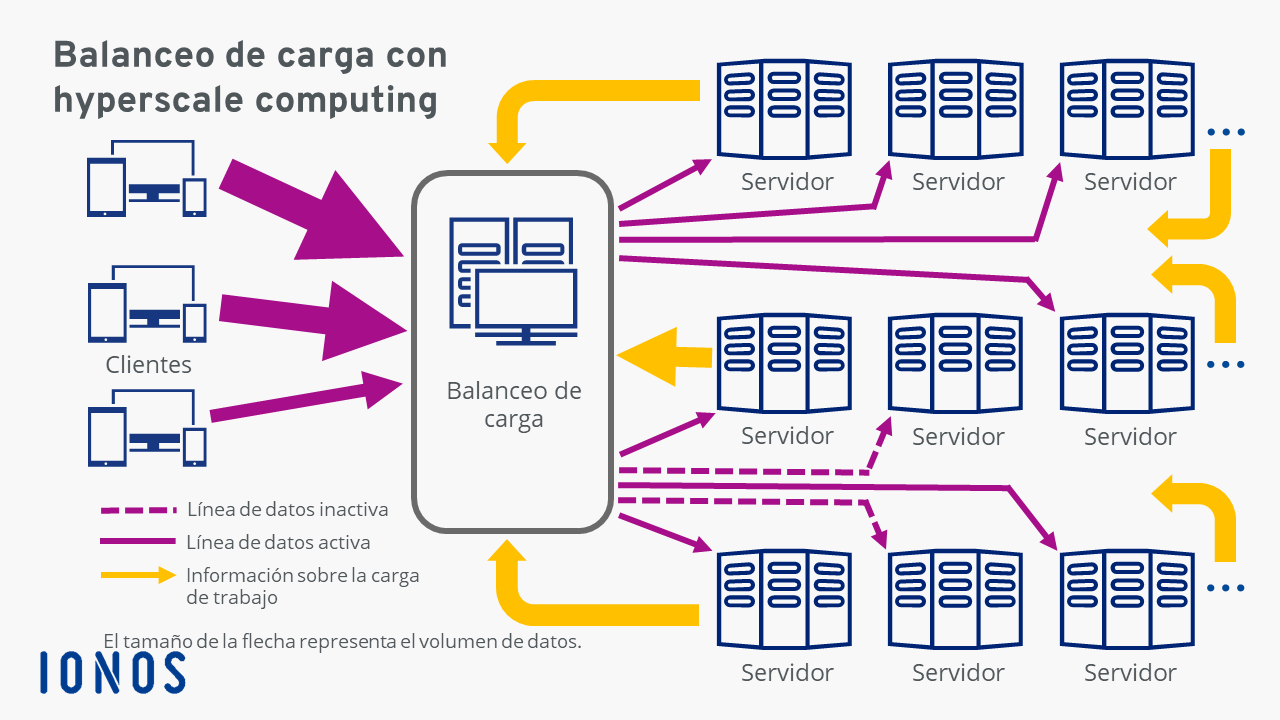

El “direccionamiento” de los servidores requeridos en un momento determinado se lleva a cabo con un ordenador que administra las solicitudes entrantes y las distribuye a las capacidades libres, el llamado balanceo de carga o load balancer. Este supervisa constantemente en qué medida la capacidad a la que están funcionando los servidores concuerda con los volúmenes de datos a procesar y, si es necesario, activa o desactiva servidores adicionales a medida que cambia el número de solicitudes.

Diversos análisis han demostrado que, en las empresas, solo entre el 25 %y el 30 % de los datos disponibles se utilizan activamente. Entre los datos no utilizados están las copias de seguridad, los datos de clientes o de recuperación, etc. Si el sistema no está bien organizado, estos datos son difíciles de encontrar cuando se necesitan, y las copias de seguridad pueden tardar días. El hyperscale computing simplifica todo este proceso. La totalidad del hardware de computación, almacenamiento y redes tiene un solo punto de contacto con las copias de seguridad, sistemas operativos y otros programas. La combinación de hardware e instalaciones auxiliares permite ampliar el entorno informático requerido en ese momento a miles de servidores.

Así, se evitan las copias superfluas de datos y se simplifica la aplicación de las políticas y los controles de seguridad en las empresas, lo que reduce los costes de personal y administrativos.

Ventajas e inconvenientes del hyperscale computing

La posibilidad de ampliar o reducir fácilmente la capacidad de los servidores es una espada de doble filo.

Ventajas

- No hay límites a la escalabilidad, lo que permite a las empresas estar preparadas de manera flexible para futuros volúmenes de datos y adaptarse al mercado de forma rápida y versátil.

- Las empresas deben tener estrategias a largo plazo para el desarrollo de sus propias tecnologías de la información.

- Los proveedores de hyperscale computing garantizan un alto grado de fiabilidad a través de soluciones redundantes.

- Se evitan las dependencias mediante el uso simultáneo de varios proveedores.

- La transparencia y la alta eficiencia en términos de costes ayudan a las empresas a alcanzar sus objetivos de manera óptima.

Inconvenientes

- Los datos se entregan sin control.

- Las capacidades de almacenamiento/servidor recién añadidas pueden generar errores.

- Se crean mayores exigencias en términos de gestión interna y responsabilidad de los empleados, aunque esto supone una ventaja a largo plazo.

- Los usuarios se vuelven dependientes del modelo de precios del proveedor de hyperscale.

- Cada proveedor tiene su propia interfaz de usuario.

Para equilibrar las ventajas e inconvenientes, las empresas pueden optar por una solución mixta y almacenar grandes copias de seguridad o datos raramente utilizados en la nube. Así, los datos no ocupan la capacidad de almacenamiento de un centro de datos interno. Por ejemplo, se puede recurrir a esta opción para los datos personales de los usuarios de una tienda en línea, que se deben consultar o eliminar a petición de los usuarios, o datos de empresa que deben guardarse.

¿Qué es un hyperscaler?

Un hyperscaler es el operador de un centro de datos que ofrece servicios de computación en nube escalables. Amazon fue la primera empresa en entrar en este mercado en 2006 con Amazon Web Services (AWS). Se trata de una filial que ha ayudado a optimizar el uso de los propios centros de datos de Amazon en todo el mundo. Entretanto, AWS ofrece una amplia gama de servicios específicos. Su cuota de mercado es de aproximadamente el 40 %. Los otros dos grandes actores en este mercado son Microsoft, con el servicio Azure (2010), y Google Cloud Platform (2010). IBM también es un importante proveedor de hyperscale computing. Puedes aprovechar estas posibilidades técnicas a través de socios autorizados que cuentan con centros de datos en España. Para muchas empresas, esto es fundamental, sobre todo desde la entrada en vigor de la nueva normativa de protección de datos.

Con Cloud Empresarial de IONOS IONOS presenta una alternativa a los grandes hyperscaler estadounidenses. El foco se centra en la infraestructura como servicio (IaaS, del inglés Infrastructure as a Service).