Tokens de IA: definición, funcionamiento y cálculo

En IA, los tokens representan la unidad lingüística más pequeña que los modelos de inteligencia artificial necesitan para poder procesar e interpretar texto. Con la ayuda del proceso de tokenización de IA, el lenguaje se descompone en estas unidades básicas o tokens, lo que constituye la base para el análisis y la generación de textos. Gracias a herramientas como el Tokenizer de OpenAI, es posible determinar de manera sencilla y rápida los tokens de un texto.

Definición: ¿qué son los tokens de IA?

Los tokens de inteligencia artificial (Artificial Intelligence Tokens) representan las unidades de datos más pequeñas que necesitan los diferentes modelos de IA, como ChatGPT, LLama2 o Copilot, para procesar, interpretar y generar textos. Cuando un texto se divide en tokens, la inteligencia artificial es capaz de entender el lenguaje y, por tanto, de proporcionar respuestas que se ajustan a las consultas de los usuarios. Los tokens de IA pueden consistir tanto de palabras completas, como de partes de palabras, signos de puntuación o incluso emojis.

El número de tokens de IA en un texto depende de varios factores, como la longitud del texto, el idioma utilizado y el modelo de IA que se emplea. Por ejemplo, si usas un acceso API como la API de ChatGPT, la cantidad de tokens va a influir directamente en los costes generados, ya que en la mayoría de los casos las aplicaciones de IA facturan según el número de tokens de IA utilizados.

- Crea tu página web en tiempo récord

- Impulsa tu negocio gracias al marketing por IA

- Ahorra tiempo y obtén mejores resultados

¿Cómo funciona la tokenización de IA?

El proceso mediante el cual un modelo de inteligencia artificial convierte un texto en tokens se denomina tokenización de IA. Este paso es esencial porque los Large Language Models, o modelos de lenguaje extensos, necesitan transformar el lenguaje natural en un formato que pueda ser analizado por máquinas. La tokenización es, por tanto, la base para la interpretación de textos, el reconocimiento de patrones y la generación de respuestas. Sin este proceso, la inteligencia artificial no podría comprender las relaciones y los significados contextuales. Este proceso de transformación del texto en tokens consta de varias etapas, que son las siguientes:

-

Normalización: en un primer paso, el modelo de IA convierte el texto en una forma estandarizada para reducir la complejidad y la variabilidad. Durante este proceso de normalización, el texto completo se transforma en minúsculas, se eliminan los caracteres especiales y, en algunos casos, las palabras se simplifican a sus formas base.

-

División del texto en tokens: a continuación, la IA descompone el texto en tokens, es decir, en unidades lingüísticas más pequeñas. La forma en que se dividen los componentes del texto depende de la complejidad y el entrenamiento del modelo. Por ejemplo, la frase “La IA revoluciona los estudios de mercado” se compone de doce tokens en GPT-3, once en GPT-3.5 y GPT-4, y solo nueve en GPT-4o.

-

Asignación de valores numéricos: al final, el modelo de inteligencia artificial asigna a cada token un valor numérico, conocido como el ID del token. Estos ID o valores numéricos constituyen el vocabulario de la inteligencia artificial, que incluye todos los tokens que el modelo ha ido aprendiendo.

-

Procesamiento de los tokens de IA: el modelo de lenguaje analiza las relaciones entre los tokens para identificar patrones y generar predicciones o respuestas. Estas se basan en probabilidades. El modelo de IA evalúa el contexto y determina los próximos tokens teniendo en cuenta los tokens anteriores.

- Una plataforma diseñada para los modelos de IA más potentes

- Precios justos y transparentes basados en tokens

- Código abierto, sin vendor lock-in

¿Cómo se calculan los tokens de un texto?

La forma en la que la IA calcula los tokens se puede analizar mediante herramientas llamadas tokenizers o tokenizadores, que descomponen el texto en sus unidades mínimas de procesamiento. Estos utilizan algoritmos específicos que se basan en los datos de entrenamiento y la arquitectura del modelo de IA. Además de mostrar el número de tokens, estas herramientas proporcionan información detallada sobre cada token como, por ejemplo, su correspondiente ID numérico. Esto no solo permite calcular los costes de manera más eficiente, sino también optimizar los textos para su uso en modelos de IA.

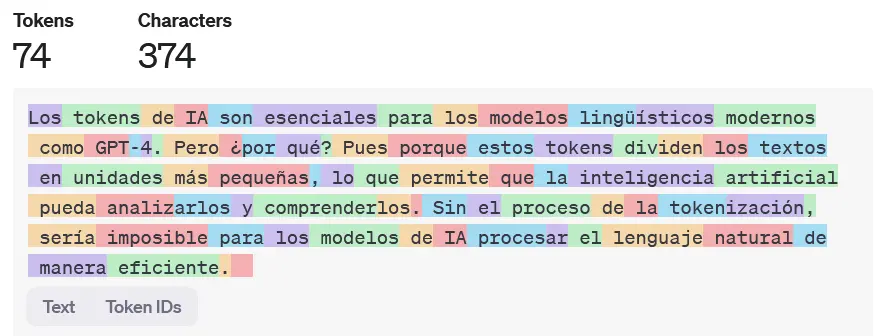

Un ejemplo de tokenizador accesible es el OpenAI Tokenizer, diseñado para los modelos de ChatGPT actuales. Tras introducir el texto en el campo de entrada, la herramienta muestra cada uno de los tokens de IA resaltados en color.

El límite máximo de un texto siempre depende del límite de tokens del modelo correspondiente. El modelo GPT-4, por ejemplo, puede procesar hasta 32 768 tokens por solicitud.

Los tokens de IA y la tokenización: un ejemplo práctico

Para ilustrar mejor el proceso de tokenización de IA, a continuación, se muestra un texto breve como ejemplo:

Los tokens de IA son esenciales para los modelos lingüísticos modernos como GPT-4. Pero ¿por qué? Pues porque estos tokens dividen los textos en unidades más pequeñas, lo que permite que la inteligencia artificial pueda analizarlos y comprenderlos. Sin el proceso de la tokenización, sería imposible para los modelos de IA procesar el lenguaje natural de manera eficiente.

El modelo GPT-4o divide este texto, que contiene 374 caracteres, en 74 tokens, como se muestra a continuación: