Apache Spark: definición y funciones

Comparado con predecesores como Hadoop o con competidores como PySpark, Apache Spark se caracteriza por un rendimiento impresionantemente rápido, uno de los aspectos más importantes a la hora de consultar, procesar y analizar grandes cantidades de datos. Como framework de big data y análisis In Memory, Spark ofrece numerosas ventajas para el análisis de datos, el aprendizaje automático, el streaming de datos y SQL.

¿Qué es Apache Spark?

Apache Spark, el framework de análisis de datos de Berkeley, se considera actualmente una de las plataformas de big data más populares en todo el mundo y es un “Top Level Project” de la Apache Software Foundation. Este motor de análisis se utiliza para procesar simultáneamente grandes cantidades de datos y aplicaciones de análisis en clústeres informáticos distribuidos. Spark se desarrolló para satisfacer las necesidades de la big data en términos de velocidad de cálculo, extensibilidad y escalabilidad.

Para ello, ofrece módulos integrados que proporcionan muchas ventajas para el cloud computing, el machine learning, aplicaciones de IA, así como streaming y datos gráficos. El motor es utilizado incluso por grandes proveedores como Netflix, Yahoo e eBay debido a su rendimiento y escalabilidad.

¿Qué hace especial a Apache Spark?

Apache Spark es un motor significativamente más rápido y potente que Apache Hadoop o Apache Hive. Procesa los trabajos 100 veces más rápido en comparación con MapReduce de Hadoop cuando el procesamiento se produce en memoria y 10 veces más rápido cuando se produce en disco. Así pues, Spark ofrece a las empresas un rendimiento que reduce costes y aumenta la eficiencia.

Sin embargo, lo más interesante de Spark es su flexibilidad. El motor no solo puede ejecutarse de forma independiente, sino también en clústeres Hadoop controlados por YARN. Además, permite a los desarrolladores escribir aplicaciones para Spark en varios lenguajes de programación. No solo SQL, sino también Python, Scala, R o Java.

Otras características especiales de Spark: no tiene que configurarse en el sistema de archivos de Hadoop, sino que también puede funcionar con otras plataformas de datos como AWS S3, Apache Cassandra o HBase. Además, si se especifica la fuente de datos, procesa tanto procesos por lotes y en Hadoop como datos de flujo y diferentes cargas de trabajo con un código casi idéntico. Con un proceso de consulta interactivo, los datos actuales e históricos en tiempo real, incluidos los análisis, pueden distribuirse en varias capas en el disco duro y la memoria y procesarse en paralelo.

¿Cómo funciona Spark?

El modo de funcionamiento de Spark se basa en el principio jerárquico primario-secundario también conocido como principio maestro-esclavo. Para ello, el controlador de Spark actúa como nodo maestro gestionado por el administrador del clúster. Éste, a su vez, controla los nodos esclavos y reenvía los análisis de datos al cliente. Las ejecuciones y consultas se distribuyen y supervisan a través del SparkContext creado por el controlador Spark, que coopera con gestores de clúster como los que ofrecen Spark, YARN, Hadoop o Kubernetes. Esto también crea Resilient Distributed Datasets (RDD).

Spark determina qué recursos se utilizan para consultar o almacenar datos, o dónde se envían los datos consultados. Al procesar dinámicamente los datos directamente en la memoria de trabajo de los clústeres de servidores, el motor reduce la latencia y ofrece un rendimiento muy rápido. Además, ofrece pasos de procesamiento en paralelo y el uso de memoria virtual y física.

Apache Spark también procesa datos procedentes de varios almacenes de datos. Estos incluyen el Hadoop Distributed File System (HDFS) y almacenes de datos relacionales como Hive o bases de datos NoSQL. Además, existe un procesamiento en memoria o basado en disco que mejora el rendimiento, en función del tamaño de los conjuntos de datos.

Los RDD como conjuntos de datos distribuidos y tolerantes a fallos

Los Resilient Distributed Datasets son una base importante de Apache Spark para el procesamiento de datos estructurados o no estructurados. Se trata de agregaciones de datos tolerantes a errores que Spark distribuye a clusters de servidores mediante clustering y procesa en paralelo o traslada a almacenes de datos. También es posible pasar los datos a otros modelos de análisis. Los conjuntos de datos de los RDD se subdividen en particiones lógicas que pueden recuperarse, recrearse o editarse, y calcularse mediante transformaciones y acciones.

Con Linux Hosting de IONOS utilizas una base de datos acorde a tus necesidades (escalable, con SSL y protección DDoS así como servidores alemanes seguros).

DataFrames y Datasets

Otros tipos de datos que procesa Spark se denominan DataFrames y Datasets. Los DataFrames son APIs como tablas de datos estructuradas en filas y columnas. Los Datasets, por su parte, son una extensión de DataFrames para una interfaz de usuario orientada a objetos para programación. Especialmente en relación con la Machine Learning Library (MLlib), los DataFrames desempeñan un papel importante como API con una estructura uniforme en todos los lenguajes de programación.

¿Qué lenguaje utiliza Spark?

Spark se desarrolló en Scala, que también es el lenguaje principal del motor Spark Core. Además, Spark ofrece conectores Java y Python. Con Spark y en combinación con otros lenguajes, Python ofrece muchas ventajas para un análisis de datos eficaz, especialmente para la ciencia de datos y la ingeniería de la información. Spark también admite interfaces API de alto nivel para el lenguaje de programación de ciencia de datos R, pudiéndose aplicar a grandes conjuntos de datos y utilizarse para el aprendizaje automático.

La importancia de Spark

Las diversas bibliotecas y almacenes de datos de Spark, las API compatibles con muchos lenguajes de programación y el eficaz procesamiento en memoria lo hacen adecuado para una amplia gama de sectores. Cuando se trata de procesar, consultar o calcular grandes cantidades de datos complejos, la alta velocidad, escalabilidad y flexibilidad de Spark ofrecen un gran rendimiento, especialmente para aplicaciones de big data de grandes empresas. Por ello, Spark es popular en la publicidad digital y el comercio electrónico, en empresas financieras para la evaluación de datos financieros o para modelos de inversión, así como para simulaciones, inteligencia artificial y previsión de tendencias.

Los aspectos más importantes de Spark incluyen:

- procesamiento, integración y recopilación de conjuntos de datos procedentes de una amplia gama de fuentes y aplicaciones

- consulta y análisis interactivos de big data

- análisis de flujos de datos en tiempo real

- aprendizaje automático e inteligencia artificial

- grandes procesos ETL

Benefíciate de servidores dedicados con procesadores Intel o AMD en ubicaciones alemanas y ahorra en tu infraestructura con servidores administrados de IONOS.

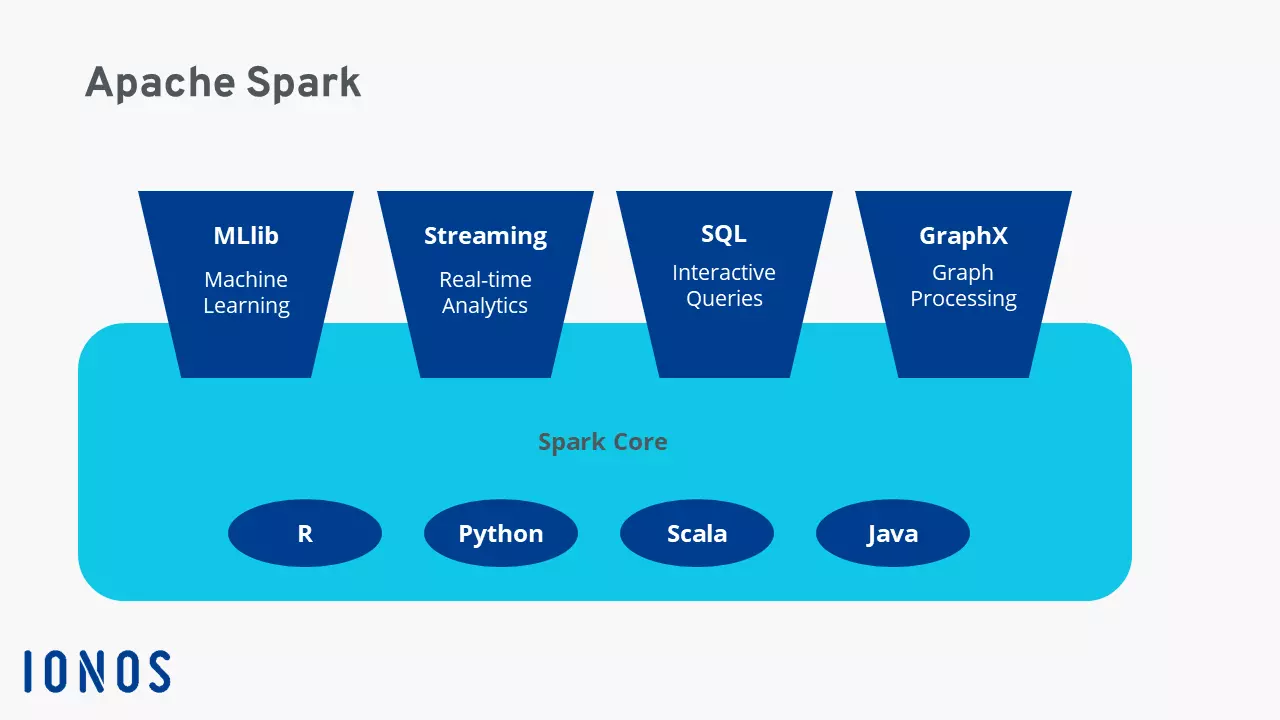

Componentes y bibliotecas importantes de la arquitectura Spark

Los elementos más importantes de la arquitectura Spark incluyen:

Spark Core

Como base de todo el sistema Spark, Spark Core proporciona las funciones básicas de Spark y gestiona la distribución de tareas, la abstracción de datos, la planificación del desarrollo y los procesos de entrada y salida. Spark Core utiliza RDDs distribuidos a través de múltiples clusters de servidores y ordenadores como estructura de datos. También constituye la base de Spark SQL, las bibliotecas, Spark Streaming y todos los demás componentes individuales importantes.

Spark SQL

Se trata de una biblioteca de uso especialmente frecuente con la que se pueden utilizar los RDD como consultas SQL. Para ello, Spark SQL genera tablas DataFrames temporales. Con Spark SQL se puede acceder a diversas fuentes de datos, trabajar con datos estructurados y utilizar consultas de datos a través de SQL y otras API de DataFrame. Además, Spark SQL te permite integrar el lenguaje de sistema de base de datos HiveQL para acceder a un data warehouse gestionada con Hive.

Spark Streaming

Con esta funcionalidad de API de alto nivel, se pueden utilizar funciones de flujo de datos altamente escalables y resistentes a errores, y se pueden procesar o visualizar flujos de datos continuos en tiempo real. Spark genera paquetes individuales para acciones de datos a partir de los flujos de datos. De esta forma, los modelos de machine learning enseñados también pueden utilizarse en flujos de datos.

MLIB Machine Learning Library

Esta biblioteca escalable de Spark proporciona código de machine learning para aplicar procesos estadísticos avanzados en clústeres de servidores o para desarrollar aplicaciones analíticas. Se incluyen algoritmos de aprendizaje comunes como clustering, regresión, clasificación y recomendación, servicios de flujo de trabajo, evaluación de modelos, estadística lineal distribuida y álgebra o transformaciones de características. Con MLlib, el machine learning puede escalarse y simplificarse de forma eficaz.

GraphX

La API GraphX de Spark se utiliza para el cálculo paralelo de gráficos y combina ETL, procesamiento interactivo de gráficos y análisis exploratorio.

¿Cómo se creó Apache Spark?

Apache Spark se desarrolló en 2009 en la Universidad de California, Berkeley, como parte de AMPlabs. Spark está a disposición del público de forma gratuita como licencia de código abierto desde 2010. La continuación y optimización de Spark comenzó en 2013 por parte de la Apache Software Foundation. La popularidad y el potencial de este framework de big data hicieron que la ASF declarara a Spark “Top Level Project” en febrero de 2014. La versión 1.0 de Spark se publicó entonces en mayo de 2014. Actualmente (abril de 2023), Spark se encuentra en la versión 3.3.2.

El objetivo de Spark era acelerar las consultas y tareas en los sistemas Hadoop. Con Spark Core como base, permitía el envío de tareas distribuidas, funcionalidades de entrada-salida, así como el procesamiento en memoria para superar a MapReduce, habitual en el framework Hadoop hasta entonces.

¿Qué ventajas ofrece Apache Spark?

Spark ofrece las siguientes ventajas para consultar y procesar rápidamente grandes cantidades de datos:

- Velocidad: las cargas de trabajo pueden procesarse y ejecutarse hasta 100 veces más rápido en comparación con MapReduce de Hadoop. Las ventajas de rendimiento adicionales se deben a la compatibilidad con el procesamiento de datos por lotes y en flujo, los gráficos acíclicos dirigidos, un motor de ejecución física y la optimización de consultas.

- Escalabilidad: gracias al procesamiento In Memory de datos distribuidos en clústeres, Spark ofrece escalabilidad flexible de recursos bajo demanda.

- Uniformidad: Spark sirve como framework de big data que unifica varias funciones y bibliotecas en una sola aplicación. Entre ellas se incluyen las consultas SQL, DataFrames, Spark Streaming, MLlib para el machine learning y GraphX para el procesamiento de gráficos. Además, cuenta con la integración de HiveQL.

- Facilidad de uso: gracias a las interfaces API de fácil uso para una amplia variedad de fuentes de datos, así como a más de 80 operadores comunes para el desarrollo de aplicaciones, Spark agrupa numerosas posibilidades de aplicación en un único framework. También resulta especialmente práctico el uso interactivo de shells Scala, Python, R o SQL para escribir servicios.

- Framework de código abierto: a través de su enfoque de código abierto, Spark ofrece una comunidad global y activa de expertos que desarrollan Spark continuamente, cierran las brechas de seguridad y garantizan una rápida innovación.

- Incremento de la eficiencia y reducción de costes: dado que Spark también se puede utilizar sin estructuras físicas de servidores de gama alta, esta plataforma para análisis de big data ofrece funcionalidades que reducen costes y mejoran el rendimiento, especialmente para algoritmos de machine learning de cálculo intensivo y complejos procesos de datos en paralelo.

¿Qué desventajas tiene Apache Spark?

A pesar de todos sus puntos fuertes, Spark también tiene algunas desventajas. La primera y más importante es el hecho de que Spark no tiene un motor de memoria integrado y, por tanto, depende de muchos elementos repartidos. El procesamiento en memoria también requiere mucha RAM, lo que puede afectar al rendimiento si los recursos son insuficientes. Además, el uso de Spark requiere un periodo de aprendizaje más largo para comprender los procesos en segundo plano cuando se instala un servidor Apache de forma independiente u otras estructuras en la nube.